Menos conversación y más acción.

Doers space en Argentina.

Dime si has hecho

algo.-

Leonardo Da Vinci.

Siempre se dijo que en la Argentina tenemos una excelente

calidad de profesionales, que somos creativos a la hora de buscar soluciones y

de inventar nuevos productos. Sin caer en clichés como el colectivo y la

birome, generalmente los ingenieros y diseñadores argentinos se destacan cuando

interactúan en grupos de trabajo internacionales. Pero, ¿por qué eso no se

traduce en, por ejemplo, cantidad de patentes registradas?

A diferencia de lo que sucede en otros lugares, en Argentina

es muy complicado a acceder a capital para lograr pruebas de concepto y, mucho

menos, a lugares donde dichas pruebas se puedan realizar. Es complejo para el inventor

promedio invertir en maquinaria, moldería, diseño, etc., para materializar su

idea.

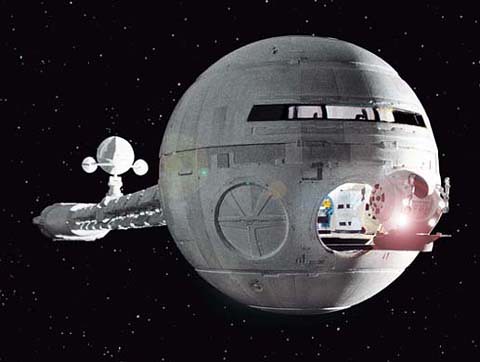

Por otro lado, contrariamente a lo suponía, uno de las

empresas que más me impactó en Silicon Valley, no fue de informática, sino un “doers

space”. Techshop es una empresa que da lugar y maquinaria apta a lo que ellos

llaman “hacedores”. Gente que se interesa por crear, materializar ideas, hacer

que conceptos se conviertan en realidad. Desde inventores de garaje (concepto

muy arraigado en EE.UU.) hasta artistas o estudiantes, todos interactuando en

el mismo espacio físico, accediendo a maquinarias, asesoramiento y cursos para

realizar su sueño. Todos interactuando y colaborando entre sí, potenciando el

espíritu emprendedor y la innovación cruzada entre distintas áreas de

conocimiento.

¿Qué pasaría si se establece un Techshop en Argentina? ¿Si

unimos ese potencial creativo con las herramientas?¿Si creamos un espacio donde

la diversión, el trabajo, los sueños y la innovación se junten? ¿Y si a ese

espacio le sumamos un toque social, enseñando oficios, dando acceso a colegios

técnicos y estudiantes universitarios a bajo costo? ¿Y si potenciamos

interacciones entre artistas plásticos que quieran crear grandes obras sin depender

de premios o subsidios?

Mi hipótesis es que podría ser un gran éxito, que en poco

tiempo de establecido estaríamos generando patentes de nuevos productos,

estaríamos cumpliendo un rol social dando oficios a personas que hoy no lo

tienen, estaríamos innovando realmente.

Mi hipótesis es que podría ser un gran éxito, que en poco

tiempo de establecido estaríamos generando patentes de nuevos productos,

estaríamos cumpliendo un rol social dando oficios a personas que hoy no lo

tienen, estaríamos innovando realmente.

Quizás la visión esté sesgada por mi profesión y mi

fracasado espíritu de inventor (de vez en cuando abro la carpeta con “ideas

geniales que nunca llevaré a cabo”). Por eso este es el primer test de concepto

de la idea. ¿Les parece que puede funcionar acá un “doers space”? ¿Conocen

gente que pagaría una cuota social (tipo club) para fabricar sus sueños? ¿Cuánto

estarían dispuestos a pagar? ¿Les parece que puede ser una idea interesante para

artistas?

Me interesaría de sobremanera escuchar sus opiniones,

difundan la idea a sus amigos, compartan el link, comenten aquí o a mi casilla

de mail ajmrepetto at gmail.com.

Alejandro Repetto

@ajmrepetto